Chat GPT-4 o mini의 API를 이용해 채팅 서비스를 구현하고 지난 포스팅에도 관련 글을 등록 했었다.

시간을 좀 가지고 진행하려 했는데 궁금증이 폭발하다 보니 바로 Ollama 3.1을 라즈베리파이에 다운하여 확인 들어가기 시작했다.

결론부터 요약하자면,

llama 3.1 중 가장 작은 8B모델을 다운로드하였음에도 API를 이용한 채팅 서비스에는 무리가 있다고 판단을 내렸다.

CLI 환경에서는 아주 느리지만 그래도 대화가 된다. 그래도 llama 3.0보다는 한글이 처리가 좀 더 잘 되는 것 같았지만 그래도 뜬금없는 영문이 튀어나오곤 했다.

이때, 라즈베리파이의 메모리는 8MB에 육박하게 된다. 이를 API로 호출할 때마다는 또 다른 상황인 것 같다. 매번 메모리에서 로드하다 보니 더 많은 메모리 부족 현상으로 대화 자체가 진행되지 않았다. 이로 인해 swap도 4G까지 늘려보기도 했는데 결론은 ‘안된다!’로 마무리했다.

이로 인해 phi3나 gemma2와 같은 더 작은 모델로도 시도해보았으나 이건 한글이 처리가 아주 취약하고 인식도 제대로 안되는지 전혀 다른 소리를 하는 경우가 빈번했다.

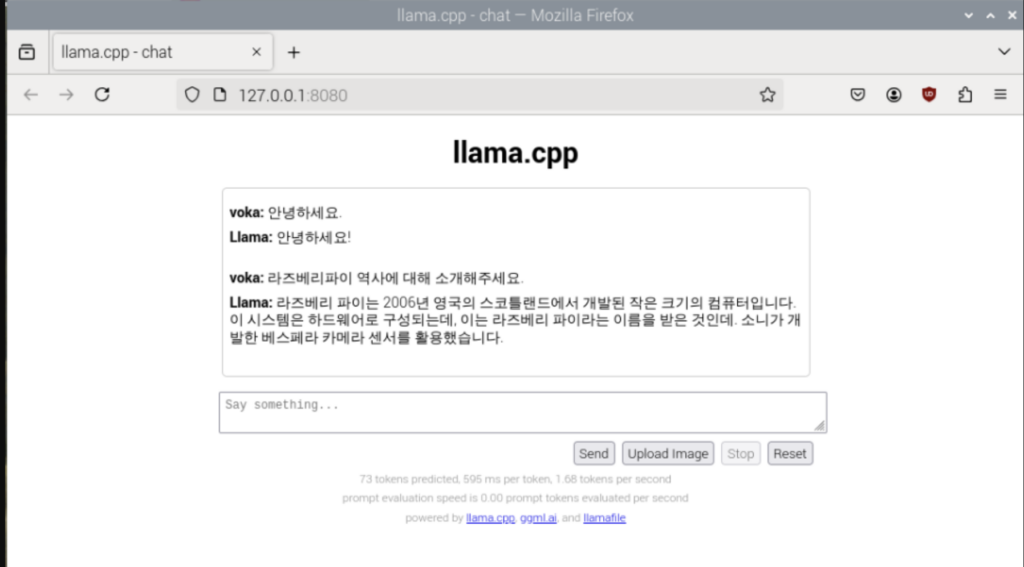

허깅페이스에 공유된 라즈베리파이용 3.1 모델을 다운로드하여 실행도 해보았는데 내 취향이 아니다.

https://huggingface.co/Mozilla/Meta-Llama-3.1-8B-Instruct-llamafile

일단, 생성성 웹 서비스를 라즈베리파이에서 구동한다는 건 칭찬하겠는데 CLI환경과 동일한 느려터진 속도가 마치 몇 개월 전 Chat GPT 4를 보는 느낌이다.

결정적으로 삼천포로 빠지는 답변에 삭제!

그리하여 Chat GPT-4o mini API로 회귀했지만 아쉬웠다.

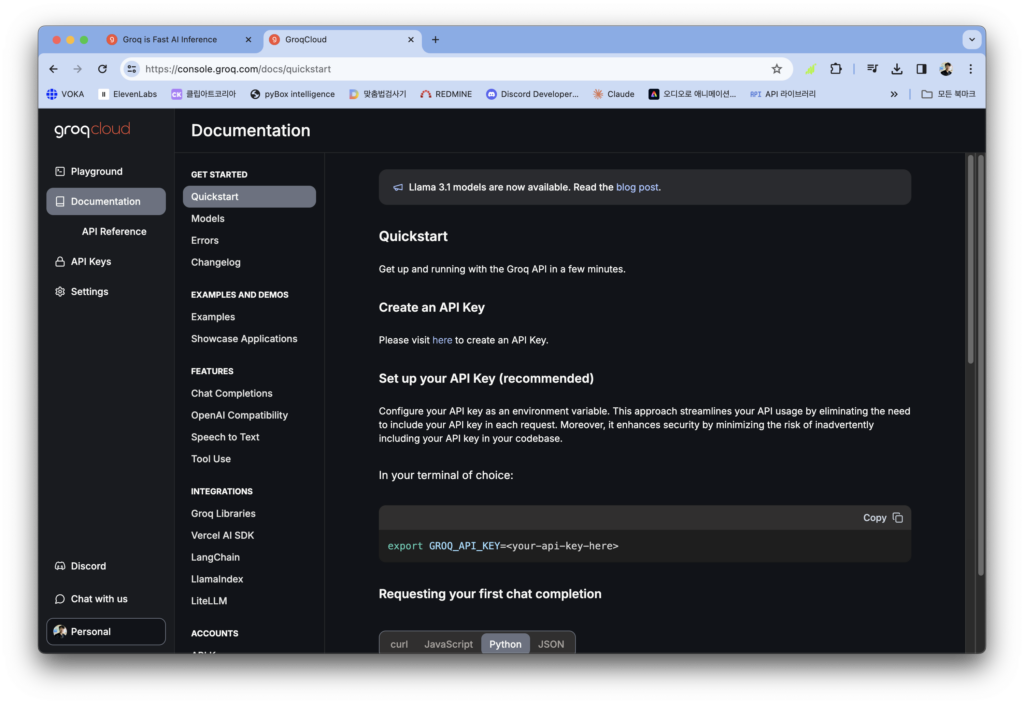

그러던 중 Groq를 API를 통한 llama 3.1 API를 무료로 사용할 수 있다는 걸 알게 되었다.

무료로 이런 서비스를 제공하다니! (세상엔 공짜 점심은 없다지만…)

아무튼 API를 훑어보고 예제코드를 보며, 기존에 Chat GPT 4 기반의 코드를 수정하여 보았다.

결론은?!

llama3.1 70B모델을 사용하였으며, Chat GPT-4o mini와 거의 같은 속도로 응답하고 있다.

아래는 속도 등을 참고할 수 있게 채팅 화면을 영상으로 만들어 보았다.

영상을 보다 보니 소스코드에 대한 들여 쓰기 쓰기 같은 걸 개선해야겠다는 게 보인다.

아무튼! 내부에 라마를 품는 건 아직까진 아닌 것 같지만 대안은 생겼으니 만족한다.

재미있고 유익하게 읽고있습니다~ ㅎㅎ

groq 들어가보니 pricing 정책이 있던데, 무료라고 하셔서요. 혹시 바뀐건가요?

OpenAI나 Clude처럼 선 결제 없이 아직도 무료로 사용하고 있는데요??? API Key 받으시고 한번 해보세요. ^^

누추한 곳 찾아주시고 댓글 남겨주셔서 감사드려요~